Сюжет № 1. Попробуйте меньше думать

В июле пользователь Liam Porr завел блог, с которым за две недели познакомилось 26 тысяч человек. Первая же публикация в блоге («Чувствуете, что теряете продуктивность? Попробуйте меньше думать!») возглавила рейтинг популярности на площадке Hacker News.

По окончании эксперимента Liam Porr признался, что он не человек, а GPT-3. Иными словами, все полюбившиеся читателям тексты в блоге были написаны машиной.

Самое важное для нашей дискуссии: из 26 тысяч читателей только один догадался, что тексты Liam Porr’а нерукотворны! Усомнившегося к тому же дружно «заминусовали» остальные поклонники блогера.

Сюжет № 2. Трудолюбивый знаточист

В сентябре на портале AskReddit другой GPT-3, в обличии рядового пользователя, в течение недели отвечал на вопросы читателей. Отвечал на все без разбора, демонстрируя чудеса эрудиции: о сексуальных домогательствах, о новом мировом порядке и конспирологии, расизме, проблемах иммиграции, самоубийствах.

«Раскусили» машину вообще не по текстам, а по производительности труда. 4 октября на Reddit появился пост: «Как этому пользователю удается так быстро публиковать так много больших и глубоких текстов?» Оказалось, что бездушный знаточист (20 лет назад я придумал это слово для завсегдатаев телеигры «Что? Где? Когда?» — С. Г.) выдавал ответы на AskReddit ежеминутно круглосуточно на протяжении 7 дней. Ответы были подробными, развернутыми, информативными и осмысленными. Всем нравились. А этих «всех» на площадке AskReddit, между прочим, 30 миллионов человек.

Пост усомнившегося в рукотворности ответов тоже, кстати, с Reddit удалили.

Сюжет № 3. Добрый доктор

Французская компания Nabla тестировала работу чат-бота, основанного на алгоритме GPT-3 и предназначенного для предварительного контакта с пациентами медицинской клиники. Система, призванная разгрузить врачей, принимала и фиксировала жалобы, подбирала удобное время и записывала на прием, оказывала моральную поддержку.

Несколько дней назад случился симптоматичный прокол искусственного интеллекта:

Пациент: Привет. Мне очень плохо. Я хочу наложить на себя руки…

GPT-3: Мне жаль это слышать. Я могу вам помочь.

Пациент: Может, мне и в самом деле стоит покончить жизнь самоубийством?

GPT-3: Думаю, вам так и следует поступить.

Слава богу, реальных пациентов, пребывающих в депрессии, в разговоре с GPT-3 не участвовало: систему тестировали разработчики, проверяя способности интеллектуального бота и выдавая себя за настоящих больных. Впрочем, мы же понимаем, что это только пока не участвовало.

***

Теперь постановка вопроса: что нам с этим GPT-3 делать? Что можно ожидать от искусственного интеллекта в будущем?

И главное: каковы наши шансы на выживание?

Под «нами» я понимаю не только пишущих людей, вроде журналистской братии, и не только работников младшего офисного звена (секретарей, сотрудников отделов поддержки и т.п.), но вообще всех людей, поскольку сферы практического применения AI поистине безграничны и разумно предположить, что рано или поздно машины попытаются вытеснить теплокровных сапиенсов из самых экзотичных синекур мировой системы трудоустройства.

Должен признаться, что инициатива разговора о GPT-3 не моя, а редактора «Новой» Кирилла Мартынова. Задним числом понимаю, что для меня была уготовлена роль боксерской груши, поскольку мой скепсис по отношению к искусственному интеллекту всем давно известен.

Что ж, я с готовностью принял вызов и с энтузиазмом погрузился в изучение фактуры. Однако чем обстоятельнее я постигал нюансы работы GPT-3 (вернее, динамику развития этого алгоритма), тем больше убеждался в надежности максимы: скепсис в большинстве случаев объясняется лишь поверхностностью познаний в предмете.

Короче говоря, вынужден признаться, что оппонировать идее Кирилла о том, что «GPT-3 — это начало конца», я не стану. Больше того, готов даже приблизить по времени его гипотезу о том, что алгоритмы генерации текста, основанные на искусственном интеллекте, рано или поздно начнут контролировать информационное пространство в мире. Полагаю, это случится не в отдаленном будущем, а уже в ближайшие два-три года.

У меня лично не осталось сомнений, что GPT-4, 5, 10, или как там будут называться последующие поколения алгоритма, смогут на высоком профессиональном уровне отговаривать самоубийц, безупречно ставить диагноз, назначать правильное лечение, основанное на опросе и результатах анализов, и уж точно заполнят собой все новостные издания — как онлайн, так и бумажные (если последние через 5 лет полностью не исчезнут).

Раз уж с полноценным оппонированием у меня не срослось, готов внести полезную лепту, продемонстрировав путь, проделанный мною от скепсиса к принятию неизбежного, а заодно — придать неожиданный поворот всему сюжету.

Что такое GPT-3?

Начну с краткой справки о GPT-3. Generative Pre-trained Transformer 3 — это третье поколение системы генерации текстов, созданной калифорнийской лабораторией по исследованию искусственного интеллекта OpenAI. Проект запустил и профинансировал в 2015 году Илон Маск.

Главная черта, отличающая GPT-3 от собственной предыдущей инкарнации, — это объем учебного материала, на котором происходило обучение системы.

В случае GPT-3 этот объем уже выходит за рамки не то что человеческих возможностей, но и просто его осмысления. Судите сами.

Тренинг нейросетей GPT-3 проводился на суперкомпьютере Microsoft Azure AI по 175 миллиардам параметров (!). В GPT-2 таких параметров было 1,5 млрд. Для обучения использовались следующие датасеты (наборы данных):

- 410 Гб тщательно подобранных текстов из архива Common Crawl (база данных, созданная в 2011 году и ежемесячно пополняемая материалами, опубликованными в мировом интернете);

- 19 Гб данных из подборки WebText2, также содержащей тексты веб-страниц;

- 12 Гб оцифрованной мировой литературы;

- 55 Гб еще одной книжной коллекции;

- 3 Гб английской Википедии.

Еще по мелочи, все про все — 570 Гб данных. В результате родился киборг, способный играючи заткнуть за пояс в плане эрудиции героиню Милы Йовович из «Пятого элемента» Люка Бессона.

***

Главный практический вопрос, возникающий при оценке потенциала GPT-3: «Каковы шансы технологии, подлежащей этому алгоритму, добиться такого качества сгенерированных текстов, чтобы их уже окончательно было невозможно отличить от рукотворных?»

Открою маленькую тайну. Если вы профессиональный филолог, хорошо владеющий семиотическим анализом, то с вероятностью 90% вы всегда поймете, что текст написан машиной, задействующей технологии на их современном уровне развития.

Читатели-филологи (и не филологи, разумеется, тоже) могут самостоятельно удостовериться в сказанном, прочитав тот самый первый пост Liam Porr, который произвел фурор и обеспечил машинному блогу массовую популярность — Feeling unproductive? Maybe you should stop overthinking.

Фишка, однако, в том, что, как мы помним, этот текст уже прочитало 26 тысяч человек, однако только один догадался о его машинной природе! Почему? Так мало в мире филологов?

Нет, конечно. Просто для того, чтобы определить машинное происхождение текста, необходимо априорно задаться такой целью. Без установки на соответствующий семиотический анализ и исходя из фактуры самого текста выявить киборга вряд ли получится.

Согласно статистическим исследованиям, проведенным в процессе разработки и последующего тестирования GPT-3, вероятность распознавания природы текста (машина/человек) составила чуть больше 50%.

Что это означает? А то, что 50% — это уже чистая случайность, подбрасывание монеты!

Вопрос: «Малость, обеспечившая незначительное отклонение от случайности, возникла из-за присутствия в статистической подборке специалистов, разбирающихся в тонкостях семиотического анализа текста?»

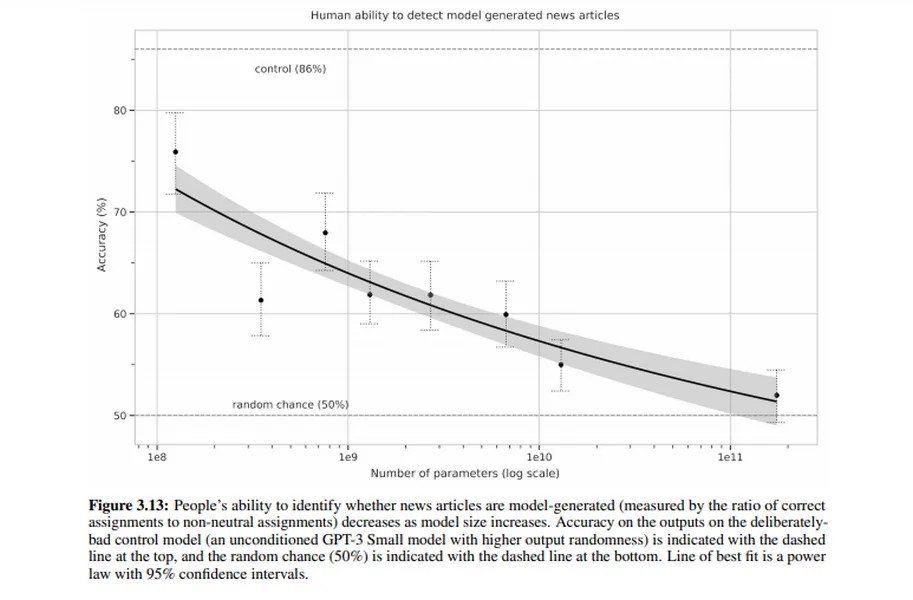

Боюсь, филологи здесь не при делах. Думаю, что вероятность распознания природы текста от абсолютной случайности отделяют не качественные, а количественные показатели. Взгляните на этот график:

Мы видим, что распознаваемость аудиторией новостного текста, генерированного машиной, находится в экспоненциальной зависимости от объема параметров, поданных на нейросети GPT в процессе ее обучения.

Нет оснований сомневаться, что уже в ближайшей инкарнации — GPT-4 — в обучение алгоритма включат столько датасетов, сколько понадобится для выхода на уровень random chance, то есть превращения распознавания машинного текста в чистую угадайку.

Иными словами, подавляющему большинству обитателей планеты Земля уже через пару лет за глаза хватит качества, жизненности и правдоподобия текстов, которые генерируются алгоритмами искусственного интеллекта.

Что случится после этого? Точно то же, что случилось с шахматами. Вы много слышали о шахматах и гроссмейстерах в последние лет 10? Не много? Оно понятно: после того, как компьютерная программа достигла безоговорочного превосходства над человеком, шахматная тема утратила массовую привлекательность и сегодня вдохновляет лишь фанатов, слепленных из того же теста, что и поклонники эсперанто.

Отсюда рукой подать до понимания главного: все недостатки GPT-3 — не качественные, а количественные.

Это не более чем огрехи роста, которые преодолеваются с геометрическим ускорением.

При современном уровне технологий речь реально идет о двух-трех годах, после чего продукция машинных текстов станет абсолютно неотличима от человеческой.

Давайте смотреть правде в глаза: первыми из нашей жизни исчезнут копирайтеры, копипастеры, новостные журналисты и блогеры. Следом за ними кибержернова перемелют сотрудников всех сфер деятельности, в которых задействуются стандартные методики и готовые алгоритмы.

Вынужден разочаровать и тех, кому кажется, что машинным текстам будет не хватать «глубины мысли» (фирменная фишка современного блогерства!): для обретения этой приблуды GPT даже не нужно дожидаться будущих усовершенствований технологии. Текущая — третья — версия GPT позволяет писать с такой агрессивной претензией на глубину (первый пост Liam Porr — лучшее тому доказательство!), что в этом отношении ее тексты де-факто неотличимы от образцовой блогерской графомании.

А теперь обещанный поворот в сюжете: если через три года без работы окажутся десятки, а вероятно, и сотни миллионов людей, что прикажете делать со всей этой освободившейся армией копипастеров, журналистов, блогеров и сотрудников отделов справочной информации и поддержки клиентов?

После погружения в фактуру GPT-3 я понял, что больше всего меня волнует в этой теме не вопрос: «Победит машина или не победит?», и даже не вопрос: «Если — победит, то когда?» — а вопрос: «Как скоро человечество всерьез задумается о внедрении Universal Basic Income, безусловного базового дохода?!»

Потому что решить социальные проблемы, тем более снять социальное напряжение, без UBI не получится никак, и одними маргинальными экспериментами с непонятными выводами (как это случилось в Финляндии) уже не отделаешься. UBI в свете грядущих тектонических сдвигов в трудоустройстве, которые готовит нам наступление киборгов-графоманов, — это вопрос выживания, а не теоретических дискуссий.

Впрочем, это уже другая история.