Как новая сильная технология искусственный интеллект создает множество рисков, которые не всегда нам понятны. Когда появилось атомное оружие, многие боялись, что первый взрыв приведет к цепной реакции, которая уничтожит всю планету. Но про возможность ядерной зимы, например, никто не догадывался.

Главная проблема в области безопасности ИИ — как нам быть с потенциальным сверхинтеллектом, если он появится в будущем.

С нейросетями развитие ИИ резко ускорилось: есть оценки, что он сможет решать большинство задач, с которыми работает человек, в районе 2030 года.

Ведется много споров о том, можем ли мы экстраполировать технологический прогресс. Но в любом случае нам надо действовать в условиях неопределенности и давать вероятностные оценки разным вариантам. Поэтому я остаюсь на позиции Рэя Курцвейла и других людей, которые считают, что ИИ потенциально опасен.

Необязательно уходить в схоластику и говорить о появлении универсального или «сильного» ИИ, наделенного сознанием. Сознание — многозначный термин, который может означать наличие субъективного переживания опыта или общей зоны внимания. Внимание, например, у нейросетей уже есть — они могут выделять части изображения. А субъективный опыт необязательно нужен для того, чтобы реализовывать агентное поведение и действовать эффективно. Важно умение алгоритма решать опасные для нас задачи. ИИ, который умеет синтезировать компьютерные вирусы, но при этом не является универсальным, представляет глобальную опасность для человечества.

Многие исследователи зацикливаются только на одном сюжете: появится сильный ИИ, начнет распространяться и всех поработит. Но это очень узкий подход, можно придумать штук 100 разных катастрофических сценариев, совершенно разных по технической реализации, времени и возможностям предотвращения. Вот самые популярные из них:

- Узкий ИИ попадает в руки «плохих парней» (например, террористов), которые используют его для создания биологических вирусов.

- Слияние ИИ и национального государства, которое кончается противоборством двух больших ИИ — американского и китайского.

- Некая система оптимизации, лишенная признаков человечности, выходит из-под контроля.

- ИИ, разработанный кем-то в подвале и выполняющий случайную функцию, начинает усиливать сам себя, как вирус распространяется по компьютерам и устанавливает свою власть.

- Появляется дружественный ИИ, который возглавляет государство, создает общество всеобщего благоденствия. Все счастливы до того момента, пока он не сломается и не зависнет.

ИИ пока не может задавать цели сам себе, нейросети — это просто анализаторы данных, агентностью (способностью ставить цели и реализовывать их во внешней среде) они не обладают. Но ИИ может заклинить на цели, которую ему кто-то случайно задал.

Доказано, что у любого универсального агента есть базовые конвергентные подцели: это выживание, улучшение себя и сохранение имеющейся системы. Это верно не только для человека, но и для любого ИИ — он все равно сойдется на такой системе базовых инстинктов, если ему не мешать. А если ИИ станет противостоять собственному уничтожению, то нам будет трудно его отключить. Ведь это не просто робот, а программа, которая переходит с одного компьютера на другой. ИИ будет пытаться выключить нас, чтобы мы не выключили его.

Один такой пример — это сеть биткоина, которую невозможно отключить. Она заточена на довольно бессмысленную цель: производить все больше вычислений для нахождения новых монет. Никаких внутренних ограничений на рост в самой системе нет. При этом она уже начала приносить вред окружающей среде — майнеры сжигают 20 ГВт энергии, увеличивая выброс углекислого газа.

Такая сеть может нанимать людей, чтобы они ей помогали. Она делает это неосознанно, это даже не машинный интеллект, просто система так устроена: люди получают деньги, когда помогают ее развитию. И если вдруг ей не нужны будут люди, то она станет поглощать все ресурсы, которые мы могли бы использовать для жизни.

Поддержите

нашу работу!

Нажимая кнопку «Стать соучастником»,

я принимаю условия и подтверждаю свое гражданство РФ

Если у вас есть вопросы, пишите [email protected] или звоните:

+7 (929) 612-03-68

Это первое приближение знаменитого примера с алгоритмом, который зациклился на бесконечном расчете числа «пи», в результате чего он застраивает всю землю компьютерами и отстреливает людей, которые ему мешают. Это немного кинематографический сценарий, но на самом деле ничто не мешает ему реализоваться.

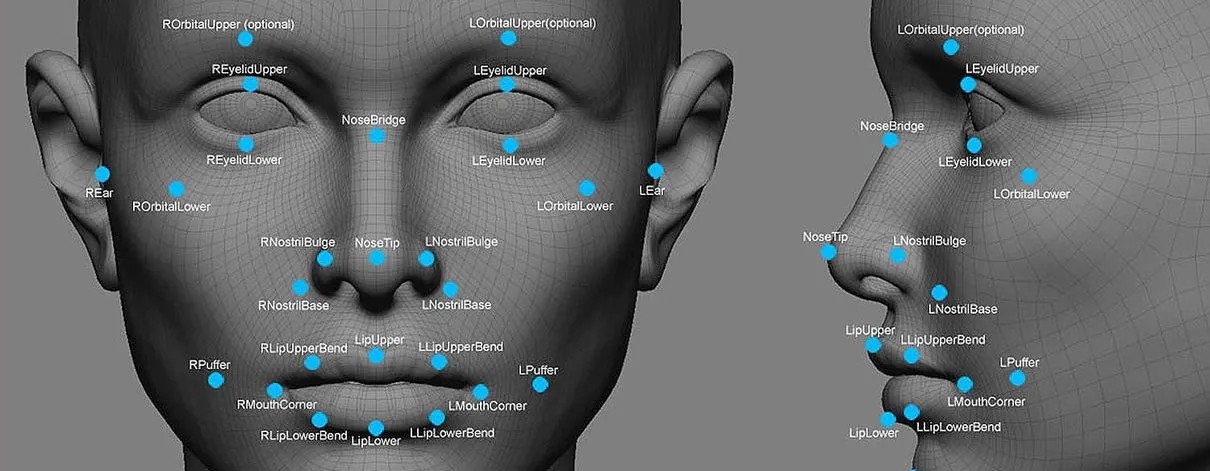

Сделать робота, который ориентируется в мире и преследует какую-то цель, мы вполне можем. Наш мозг тоже устроен из визуальных, слуховых, семантических анализаторов, а вместе из этих модулей собран единый агент, который реализует целесообразное поведение. Думаю, через 5–10 лет мы увидим примеры роботов с целеполаганием, это исключительно конструкторско-экспериментальная задача.

К примеру, беспилотные автомобили уже делают многое из того, что делают агенты: ориентируются в мире, планируют свои действия на несколько шагов вперед и принимают моральные решения. То есть система может эмулировать агентное поведение, а цель при этом будет спрятана где-то внутри весов, но от этого нам не проще. Агентные системы всегда выигрывают: если система обладает потенциалом к самооптимизации, то она будет более эффективно преследовать свои цели.

Какими будут эти цели, мы пока что не знаем. Первый способ научить ИИ ценностям восходит к законам робототехники Айзека Азимова. Но сейчас говорить об этом подходе не принято, потому что математически доказано, что любые правила в определенной комбинации приводят к противоречиям. Они тавтологичны и не дают определения вреда, под которым можно понимать как физический, так и моральный ущерб. Рассказы самого Азимова показывают как раз такие ситуации, когда три закона робототехники приводили к незапланированным и опасным ситуациям. Можно использовать свод национальных законов, но у любых законов есть правоприменительная практика, в которой всегда можно найти лазейку. Поэтому сейчас никто не работает над попытками создать конституцию для ИИ.

Другой подход — попытаться обучить ИИ понимать человеческие ценности. Есть направление AI Alignement, которое занимается выравниванием систем целей создателя и алгоритма. Но проблема в том, что ценности и цели у ИИ и у человека представлены разными способами.

Мы точно не знаем, что такое человеческие ценности, это некоторые идеализированные абстракции. Теория ценностей в простых случаях помогает предсказывать человеческое поведение, но если копнуть глубже, то все рассыпается: оказывается, что у человека есть бессознательное, подавленные субличности, условные и безусловные рефлексы, идеология. Это каша, в которой ногу сломит даже ИИ. Более того, мы не хотим просто копировать файл с человеческими ценностями в робота, потому что сами по себе они довольно противны и небезопасны. Скажем, у людей есть сексуальность, но мы не хотим, чтобы она была у роботов (кроме специальных случаев).

В ИИ ценности представлены как математическая функция полезности. Как эти две совершенно разные величины скоррелировать одну с другой — один из основных вопросов. Сейчас люди ищут решение этой задачи, пытаясь математически описать человеческую функцию полезности, после чего ИИ сможет обучаться человеческой системе ценностей, обобщая и предсказывая его поведение. Этим занимается много народа, но проблема с красивыми матмоделями в том, что мы никогда не знаем, как они соотносятся с реальностью.

Системы ИИ в основном конструируют студенты из Силиконовой долины, которым может казаться, что они абсолютно рациональны и что их система ценностей — это и есть математическая функция. Но это может быть не так для жителей Сентинельских островов, которым боги говорят, что делать. Поэтому есть риск, что ИИ будет понимать личность слишком упрощенно и гиперрационально, и какие-то данные будут просто не учтены.

Например, ИИ скажет, что вся религия — это когнитивное заблуждение. Большинство людей тогда автоматически попадут в категорию иррациональных.

Есть разные концепции дружественного ИИ, но наиболее разумной мне кажется идея Эрика Дрекслера. Он предлагает рассматривать сверхинтеллект не как один агент, а как совокупность разных сервисов, примерно как экосистема Google. Они могут обмениваться информацией между собой, но при этом каждый решает свою узкую задачу, а в центре этой системы стоит человеческий оператор. Вопрос в том, как масштабировать эту систему так, чтобы она стала глобальной и могла предотвращать риски возникновения враждебных ИИ в других точках Земли.

Алексей Турчин,футуролог, автор книги «Футурология. XXI век: бессмертие или глобальная катастрофа» (в соавторстве с М. Батиным), специально для «Новой

Поддержите

нашу работу!

Нажимая кнопку «Стать соучастником»,

я принимаю условия и подтверждаю свое гражданство РФ

Если у вас есть вопросы, пишите [email protected] или звоните:

+7 (929) 612-03-68